Google Maps est évidemment l'application de cartes et de navigation la plus populaire, non seulement sur Android mais également sur iOS. C'est l'application incontournable pour obtenir des itinéraires et rechercher des pompes à essence, des restaurants ou des hôpitaux à proximité. Cependant, un utilisateur de Twitter est tombé sur une requête de recherche désobligeante qui remet en question l'algorithme de recherche de Google, notamment parce qu'il laisse les jeunes enfants vulnérables..

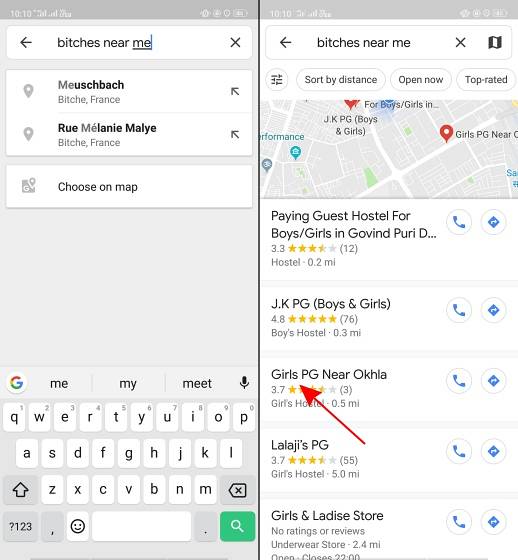

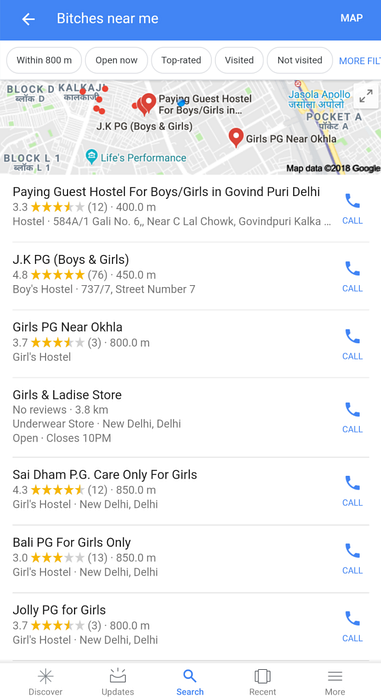

Tel que rapporté par l'utilisateur Twitter @AHappyChipmunk, si vous ouvrez Google Maps et recherchez «chiennes près de moi», le résultat de la recherche est horrible. La plate-forme reprend cet argot désobligeant (que nous condamnons) et montre des écoles de filles, des collèges, des auberges de jeunesse et des appartements payants, ce qui vous fait faire une pause d'une seconde. Dans un pays comme l'Inde où le N-mot péjoratif est utilisé par des couches ignorantes de la population pour se montrer, il n'est pas difficile d'imaginer des termes de recherche comme les chiennes.

Google, pouvez-vous expliquer pourquoi ce putain existe pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25 novembre 2018

Ce tweet est une horrible surprise, mais voir le logo d'un compte Twitter de troll (@trollenku) m'a rendu sceptique quant au tweet ci-dessus, et j'ai d'abord pensé que c'était une blague. Ce n'est qu'en utilisant nous-mêmes la même requête de recherche que nous avons réalisé qu'il ne s'agissait pas que d'écoles - l'algorithme de Google renvoie chaque lieu près de chez vous qui est lié aux filles - y compris les locations pour filles et autres auberges.

Il en va de même pour les recherches Google pour cette phrase:

Il faut comprendre qu'aucune personne chez Google n'est responsable de cela. L'algorithme de Google semble corréler les chiennes aux filles, ce qui remet une fois de plus en question le biais de l'IA. Après tout, une machine n'apprendra que ce que vous lui apprenez.

le le résultat de la recherche montre le côté obscur de l'IA et comment la culture pop peut vous conditionner à associer certains termes à un genre particulier. Il met également en évidence la manière dont les personnes qui créent ces algorithmes de recherche pensent. Google devrait être particulièrement méfiant après le débrayage massif des employés lié au harcèlement sexuel dans ses bureaux au début du mois. La prétendue `` culture de frère '' chez Google lui a également valu un ou deux procès. Et cette dernière gaffe de l'IA survient à un moment où la visibilité est amplifiée grâce au mouvement #MeToo en Inde.

Beaucoup de gens ont tweeté à Google pour plus d'informations sur cet algorithme goof-up. Nous vous apporterons la mise à jour une fois que nous aurons reçu une réponse de la société.

Gadgetshowto

Gadgetshowto

![5050 ans en 150 secondes [Vidéo]](https://gadgetshowto.com/storage/img/images_1/5050-years-in-150-seconds-[video].jpg)